Grazer Informatiker entwickelten einen Schlussfolgerungsmechanismus.

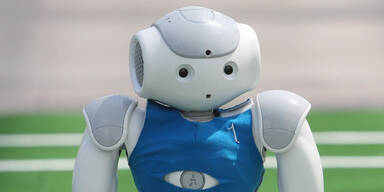

Wenn ein autonomer Roboter robust in einer dynamischen Umgebung agieren soll, so muss er in der Lage sein, mit unerwarteten oder mehrdeutigen Situationen umzugehen. Worauf sich Menschen relativ rasch einstellen können, stellt für Roboter aber nach wie vor eine große Herausforderung dar. Gerald Steinbauer und sein Team an der TU Graz wollen den autonomen Systemen "Hausverstand" beibringen.

Maschinen fehlt der Hausverstand

Serviceroboter sollen künftig zuverlässig Aufgaben lösen können, auch wenn Unvorhersehbares passiert und sich die Umgebung nicht mehr wie erwartet darstellt. Vor allem in gefährlichen Situationen wie bei Umweltkatastrophen oder Industrieunfällen oder einem Tunnelunglück wäre der Einsatz von intelligenten Robotern hilfreich. Forscher beschäftigen sich daher weltweit mit der Frage, wie die künstlichen Intelligenzen in für sie ungewöhnlichen Situationen ihre Aufgaben erledigen können. Gerald Steinbauer vom Institut für Softwaretechnologie der TU Graz betreibt mit seinen Mitarbeitern seit Jahren Grundlagenforschung zur Entwicklung des intelligenten autonomen Roboters.

"Im menschlichen Alltag passieren immer wieder Überraschungen oder kleine Irrtümer: Beispielsweise, dass man mit dem Lift im falschen Stockwerk landet oder ins falsche Zimmer geht", schilderte Steinbauer. Wenn ein Roboter jedoch nicht merkt, dass er im falschen Stockwerk oder dem falschen Raum ist, kann er seine Aufgabe nicht erfüllen, weil er schlicht und ergreifend fehl am Platz ist. Schwierig wird es für Roboter auch, wenn ihm ein Objekt aus der Greifhand fällt, wenn er aufgrund der Sensorik ein Objekt nicht erkennt oder jemand die erwartete Umgebung verändert.

Schlussfolgerungsmechanismus

"Menschen benützen Schlussfolgerungen, um mit solchen Phänomenen umzugehen und etwa Irrtümer zu entdecken, das heißt, sie denken über den Lauf der Dinge nach, um auf die Fehlerquelle oder möglicherweise Fehlinterpretation zu kommen", erklärte Steinbauer. Davon ausgehend können sie Aktionen setzen, um die Inkonsistenzen zu reduzieren. Robotersysteme verfügen bisher jedoch nur bedingt über die Fähigkeit, Standardregeln und Schlussfolgerungen, also quasi ihren Hausverstand, einzusetzen. Ähnliches versuchen die Grazer Forscher den Robotern beizubringen.

Steinbauer hat mit finanzieller Unterstützung durch den Wissenschaftsfonds FWF einen Schlussfolgerungsmechanismus entwickelt, der es Robotern erlaubt, Inkonsistenzen in ihrer Wissensbasis zu erkennen und entsprechende Aktionen abzuleiten. "Wir haben Schlussfolgerungen mit dem sogenannten Situationskalkül in Logik abgebildet. Dieses ermöglicht, die vom Roboter ausgeführten Aktionen und deren Effekte zu beschreiben", fasste Steinbauer zusammen.

Anpassung an neue Situationen

Dazu haben die Grazer Informatiker laufend automatisch Diagnosen erstellt, indem sie beobachteten, wo das Wissen des Roboters mit der aktuellen Situation nicht mehr zusammenpasst. Stimmt das Wissen mit den Anforderungen der realen Welt nicht mehr überein, wurde ihm "beigebracht", sich der neuen Situation anzupassen: "Aus dem Wissen, was eine Aktion bewirkt, lernt der Roboter abzuleiten, was er als nächstes tun muss", so Steinbauer.

Im Test habe sich das Grazer Modell bewährt: Ein Roboter, der mit einfachen Lieferaufgaben betraut war, hat sich auch durch verschobene, entfernte oder falsche Objekte oder Umgebungen nicht mehr irritieren lassen. Die Informatiker wollen nun das Wissen des Roboters kontinuierlich ausbauen. Dabei stoßen sie jedoch an die Grenzen der technischen Machbarkeit. "Autonome Systeme auszutesten fordert Computern enorme Rechenleistung ab. Wenn die Aktionskette länger wird, wird es sehr komplex und man stößt zurzeit prinzipiell rasch an die Leistungsgrenze der Rechner. Für den Forschungsalltag bedeutet das, dass es Stunden oder Tage dauern kann, bis ein Roboter ein neues Problem lösen kann." Auch im Bereich der Wahrnehmung seien noch viele grundlegende Fragen zu lösen.